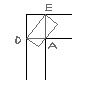

Помогите плиз... очень надо, существует такая задача, написать программку для поиска минимума функции одним из градиентных методов. Закодировать её на Си не составит труда, надо понять как реализуется сам этот алгоритм Я решил использовать метод наискорейшего спуска. Наиболее понятное для меня описание этого алгоритма я нашел в интернете, оно было такое: 1. задать (произвольно) точку начального приближения x(0); 2. в цикле по номеру итерации k=0,1,… вычислить: 3. значение вектора градиента в точке x=x(k) по формуле http://anterior1.chat.ru/01.png; 4. значение нормы (длины) вектора градиента по http://anterior1.chat.ru/04.png; 5. значение вектора единичной длины в направлении, противоположном вектору градиента s(k) по формуле http://anterior1.chat.ru/03.png; 6. значение матрицы вторых производных по http://anterior1.chat.ru/06.png; 7. значение шага по http://anterior1.chat.ru/09.png; 8. новое значение приближения x(k+1) по http://anterior1.chat.ru/02.png; 9. закончить итерационный процесс, используя условие: следует прекратить вычисления, если, начиная с k* - той итерации абсолютное значение нормированной разности между значениями функции в “соседних” не превышает наперед заданного малого числа (http://anterior1.chat.ru/10.png) Непонятен 7й пункт - вычисление лямбды. Что должно быть результатом? вектор-строка(x,y) или скалярное значение? И вообще какое значение должно получится? Вот что я здесь нарешал: http://anterior1.chat.ru/question.png

Ответ на:

комментарий

от annoynimous

Ответ на:

комментарий

от annoynimous

Вы не можете добавлять комментарии в эту тему. Тема перемещена в архив.

Похожие темы

- Форум Какая траектория у аналитического метода наискорейшего спуска [Численные метод][туплю] (2011)

- Форум Помогите понять метод шифрованя (2019)

- Форум 2all: математика, физика, численные методы, ещё чего-нибудь (2008)

- Форум Математика (2024)

- Форум Математика (2014)

- Форум Математикам (2013)

- Форум Математика. (2008)

- Форум Математика (2007)

- Форум математика (2005)

- Форум Математика (2004)