1С извеcтила пользователей и партнеров о начале поддержки процессоров Эльбрус-8С с версии 8.3.22 платформы «1С:Предприятие».

Ранее сообщество уже проводило определённые изыскания на тему возможности запуска платформы 1С на этих процессорах с использованием бинарного транслятора и с соответствующим ущербом в производительности. Логично ожидать, что сборка в родной для процессора архитектуре такой проблемы иметь не будет. Более того, правильное использование явного параллелизма в архитектуре VLIW потенциально может дать преимущество именно клиент-серверным информационным системам (к которым относится 1С:Предприятие, а также различные РСУБД) по сравнению с неявным параллелизмом внутренней архитектуры RISC современных x86-процессоров.

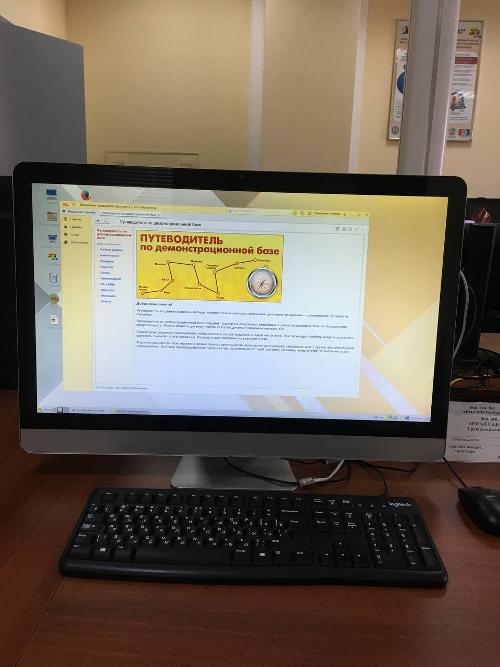

Первые сборки для зарегистрированных пользователей и партнёров доступны уже для актуальной на сегодня 8.3.22-й ветки платформы (для перехода по ссылке требуется регистрация на сайте 1С).

На снимке: машина вычислительная электронная промышленная панельная М К02 ЛКНВ.466215.019.02 (1шт Эльбрус 8С, архитектура e2kv4)

Телеграм для обсуждения: elbrus_pc_test