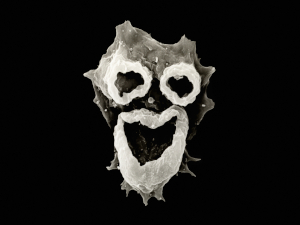

Поставил War Thunder Linux версию. Проблема в том, что даже на минимальных настройках это выглядит вот так:

http://postimg.org/image/7z4t8rum9/

http://postimg.org/image/g1lzn90ht/

..т.е. цвета, текстуры, их пересечения полностью разбиты. При каждом запуске это выглядит по разному, но в таком стиле. С чем такое связанно может быть и как исправить? Под Windows на том самом ноутбуке всё ОК.

Видеокарта Radeon HD 3470 (256MB), драйвер xf86-video-ati