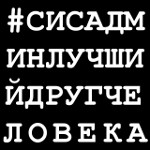

Окончательно нервы сдали с CFQ, поставил deadline, стало лучше, но не уверен, лучший ли это вариант для десктопа.

А какой у вас планировщик ввода-вывода и почему?

Окончательно нервы сдали с CFQ, поставил deadline, стало лучше, но не уверен, лучший ли это вариант для десктопа.

А какой у вас планировщик ввода-вывода и почему?