Имеется сервер с Debian и четыре жёстких диска: два старых и два новых (попарно из одинаковых партий). Планирую из всего этого собрать software raid10. Как лучше это сделать?

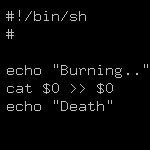

- Использовать raid10 от mdadm и добавить в него все диски.

- Собрать вручную два raid1 из пар «старый диск + новый диск» и объединить их в raid0.

- Собрать вручную два raid1 из пар «старый диск + новый диск» и объединить их с помощью LVM.

Важно:

- в будущем может появиться необходимость расширить массив путём добавления ещё нескольких дисков (суммарно их всегда будет чётное количество);

- вероятно, имеющиеся диски будут постепенно заменены на HDD большего объёма и понадобится расширить доступный объём в RAID10;

- я знаю про существование raid0+1, его плюсы и минусы - данный вариант к данной теме не относится.

Вопросы:

- Насколько сильно будет отличаться производительность операций чтения/записи в трёх случаях?

- Чем на практике отличаются указанные варианты?

- Какой вариант является самым надёжным?

- Какой вариант является самым производительным?

- Какой вариант порекомендуете на основании личного опыта с учётом требований к возможностям расширения?