Здравствуйте!

Пилю тут потихоньку свой проект. И по предварительным расчетам на среднюю нагрузку у меня получается, что на сайте в базу будет добавляться около 200 Мб в день.

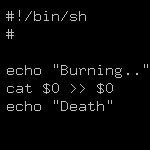

Добавляема информация - это XML описания разных объектов. В XML коде много повторяющихся тегов, так что XML описание объекта ужимается ZIP алгоритмом более чем в 10 раз.

Вот и думаю, стоит ли менять формат хранения описания объектов с чистого XML (поле типа TEXT без ограничения длинны) на упакованный XML через ZIP (поле типа BLOB)? Если и менять, то стоит ли вообще перейти с XML на JSON, он вроде более компактный, и его уже зипать?

Что лучше - хранить неупакованные данные в 10 раз больше или зипать/раззипать при чтении-записи, но объем в базе будет в 10 раз меньше?

Обращение к этим данным идет только в ответ на действия пользователей, одни данные пользователь просматривает примерно 2-3 минуты.

Ответ на:

комментарий

от Munhgauzen

Ответ на:

комментарий

от derlafff

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от Munhgauzen

Ответ на:

комментарий

от roller

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от xpahos

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от pi11

Ответ на:

комментарий

от pi11

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от xpahos

Ответ на:

комментарий

от xpahos

Ответ на:

комментарий

от pi11

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от pi11

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от dizza

Ответ на:

комментарий

от heisenberg

Ответ на:

комментарий

от Xintrea

Ответ на:

комментарий

от Xintrea

Вы не можете добавлять комментарии в эту тему. Тема перемещена в архив.

Похожие темы

- Форум ubuntu = 200 мб памяти :) (2011)

- Форум Х отъедает 200 мб Rss - как почистить? (2004)

- Форум [gcc][avr] Оптимизация делает хуже (2012)

- Форум Стоит ли делать статический glibc? (2019)

- Форум Стоит ли делать римейк UGH! (2013)

- Форум Разовая удаленная работа TCL (без TK), 1 день 200$ (2011)

- Форум Стоит ли делать игры под Linux? (2015)

- Форум Стоит ли делать сайт под лохотрон? (2018)

- Форум Чего под FreeBSD делать не стоит? (2013)

- Форум Брак ноута в день покупки - что делать? (2014)