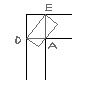

OCFS2 -> DRBD -> LVx2

То есть обычное зеркало, только по сети.

Всё это было нужно для виртуальной фермы. Итог: виртуалки мигрируют нормально (давеча пробовал на Glusterfs, так там файловые системы виртуальных машин повреждались непредсказуемым образом), но... работает всё дико медленно. Почитал официальные доки DRBD, всё предложенное там для улучшения производительности и снижения латентности рассмотрел, кое что применил (не всё мне реально подходит), в итоге производительность стала чуть выше, но всё равно просто катастрофической: простейшие тесты показывают, что DRBD более, чем в 5 раз медленнее диска, на котором она работает, и это при том, что производительность гигабитной сети почти равна производительности дискового массива!

Если кто-нибудь делал что-то подобное и добился нормальной производительности (всё-таки даже глючная GlusterFS работает в 3 раза быстрее DRBD), поделитесь советами по улучшению производительности DRBD, пожалуйста :)

Кстати, по поводу Glusterfs: может, её всё-таки стоит запускать поверх GFS/OCFS2, а не general fs?

Ответ на:

комментарий

от true_admin

Ответ на:

комментарий

от true_admin

Ответ на:

комментарий

от DRVTiny

Ответ на:

комментарий

от DRVTiny

Ответ на:

комментарий

от shahid

Ответ на:

комментарий

от shahid

Ответ на:

комментарий

от shahid

Ответ на:

комментарий

от shahid

Ответ на:

комментарий

от dimon555

Ответ на:

комментарий

от dimon555

Ответ на:

комментарий

от DRVTiny

Ответ на:

комментарий

от DRVTiny

![]()

Вы не можете добавлять комментарии в эту тему. Тема перемещена в архив.

Похожие темы

- Форум drbd+ocfs2+hearbeat (2010)

- Форум smbd+ctdb+drbd+(ocfs2||gfs2) (2015)

- Форум [drbd] Проблемы с производительностью. (2011)

- Форум DRBD - низкая производительность на запись (2013)

- Форум ocfs2 + openvz (2011)

- Форум drbd (2002)

- Форум OCFS2 и перезагрузки (2012)

- Форум GFS vs OCFS2 (2010)

- Форум ocfs2 vs gfs2 (2007)

- Форум ocfs2 низкая скорость (2022)