Выпущена первая версия сервера хранения данных с доступом по протоколу HTTP, предназначенная для решения проблемы большого количества маленьких файлов на файловых системах, в том числе кластерных.

Некоторые возможности:

- многопоточность;

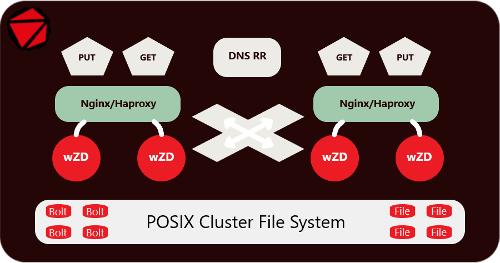

- мультисерверность, обеспечивающая отказоустойчивость и сбалансированность нагрузки;

- максимальная прозрачность для пользователя или разработчика;

- поддерживаемые методы HTTP: GET, HEAD, PUT и DELETE;

- управление поведением при чтении и записи через клиентские заголовки;

- поддержка гибко настраиваемых виртуальных хостов;

- поддержка целостности данных CRC при записи/чтении;

- полудинамические буферы для минимального потребления памяти и оптимальной настройки сетевой производительности;

- отложенная компакция данных;

- как дополнение — многопоточный архиватор wZA для миграции файлов без остановки сервиса.

Продукт предназначен для смешанного применения, в том числе поддерживается работа с большими файлами без ущерба производительности.

Основное рекомендуемое направление использования на origin серверах и крупных хранилищах для значительного снижения количества метаданных в кластерных файловых системах и расширения их возможностей.

Сервер распространяется под лицензией BSD-3.

>>> Статья