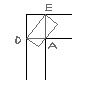

Делаю (пытаюсь) HA кластер на технологиях DRBD OCFS2 HEARTBEAT KVM Задумываю два узла node1 и node2. DRBD будет работать в режиме Primary/Primary для того что бы вторая железка не стояла (и для ремонта можно было использовать живую миграцию). В рабочем режиме vmashine1 запущена на node1, vmashine2 запущена на node2. Если что то случается с одним из узлов то обе виртуальные машины перебегаю на рабочий узел (т.е одна как работала так и работает, а вторая перебегает)

Что имею сейчас:

1) Работающий Heartbeat который переносит IP адрес.

2) DRBD кластер Primary/Primary.

Как может выглядеть решение этой задачи, алгоритм? Как для этого использовать выбранные технологии? Как я понимаю вся работа возлагается на Heartbeat. Как его можно настроить для такой работы?

Я думаю так...

haresources:

node1 1vmashine

node2 2vmashine

1vmashine...

старт {

#Проверить роль DRBD диска, изменить если требуется на Primary

#Смонтировать диск

#Запустить 1vmashine на node1

}

стоп {

#Остановить 1vmashine на node1

}

Нужно как то следить что бы не было ситуации при которой получиться что на обеих node1 и node2 запустились Одни и теже машины, а так же по возможности использовать живую миграцию)

Подскажите пожалуйста. Я не прошу готового решения просто описание решения. За примеры буду благодарен. Большое спасибо.

Александр